robots.txt ফাইল

“robots.txt” ফাইল এমন একটি ফাইল যেটা সার্চ ইঞ্জিনকে বলে যে সার্চ ইঞ্জিন একটা সাইটের কোন কোন্ পেজ crawl করবে আর কোন কোন পেজ crawl করবে না। এই robots.txt ফাইলটি রুট ফোল্ডারে থাকে। ওয়েব সাইটের কিছু পেজ সার্চ রেজাল্টে না দেখানোর প্রয়োজন হতে পারে।

কারন হতে পারে সেই পেজগুলির কাজ এখনও শেষ হয়নি বা অন্য যেকোন কারন। এজন্য একটি robots.txt ফাইল তৈরী করে সেখানে ঠিক করে দেয়া যায় যে কোন্ কোন্ পেজ Search Engine crawl করবে না।

যদি সাবডোমেইন থাকে এবং এর কিছু পেজ যদি সার্চ রেজাল্টে না দেখানোর প্রয়োজন পরে তাহলে এটার জন্য আলাদা একটা robots.txt ফাইল তৈরী করতে হবে. robots.txt ফাইলটি তৈরীর পর রুট ফোল্ডারে আপলোড করতে হয়।

Robots.txt ফাইল কি? Create Robots.txt File

Robots.txt ফাইল তৈরী

robots.txt ফাইল দিয়ে সার্চ ইঞ্জিনের বট ক্রাউলার এবং স্পাইডার সাইটের কোন্ কোন্ পেজ দেখবে এবং কোন্ কোন্ পেজ দেখবে না এসব নিয়ন্ত্রন করা যায়।

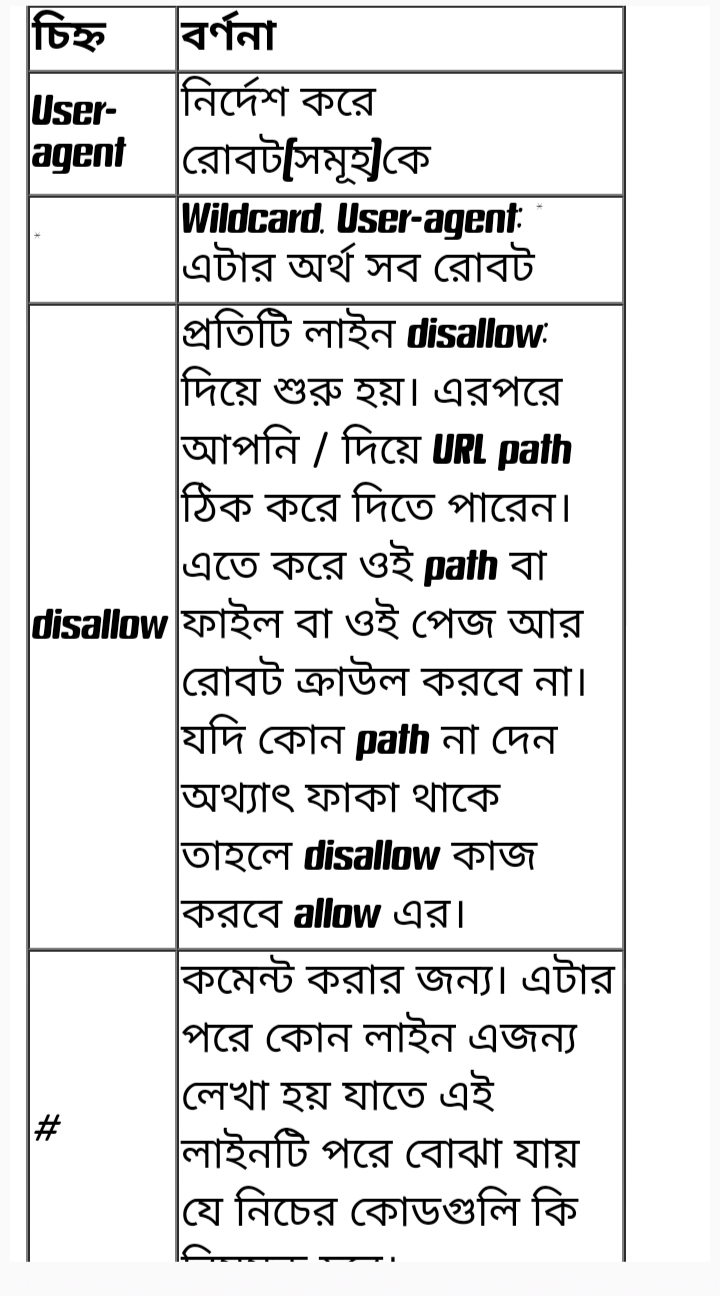

এই নিয়ন্ত্রনের পদ্ধতিকে বলা হয় রোবটস এক্সক্লুসন প্রটোকল (Robots Exclusion Protocol) বা রোবটস এক্সক্লুসন স্টান্ডার্ড (Robots Exclusion Standard) . এই ফাইল তৈরীর আগে এখানে ব্যবহৃত কিছু চিহ্ন চিনে নেয়া যাক।

Disallow ফিল্ড আংশিক বা পূর্নাঙ্গ URL উপস্থাপন করতে পারে। ” / ” চিহ্নের পর যে path উল্লেখ থাকবে সেই path রোবট ভিজিট করবে না।নিচে একটি উদাহরণ দেখুন –

উদাহরণ দেখুন

Disallow: /help #disallows both /help.html and /help/index.html, whereas

নিচে আরও একটি উদাহরণ দেখুন –

উদাহরণ দেখুন

Disallow: /help/ # would disallow /help/index.html but allow /help.html

নিচে কয়েকটি উদাহরণ দেখুন –

সব রোবটকে সমস্ত ফাইল ভিজিটের জন্য অনুমোদন করবে(wildcard “ * ” নির্দেশ করে সব রোবট)

উদাহরণ দেখুন

User-agent: * Disallow:

সব রোবট কোন ফাইল ভিজিট করবে না আমন একটি উদাহরণ দেখুন –

উদাহরণ দেখুন

User-agent: * Disallow: /

গুগলবট এর শুধু ভিজিটের অনুমোদন থাকবে বাকি কেউ ভিজিট করতে পারবে না আমন একটি উদাহরণ দেখুন –

উদাহরণ দেখুন

User-agent: GoogleBot Disallow:

গুগলবট এবং ইয়াহুস্লার্প এর শুধু ভিজিটের অনুমোদন থাকবে বাকি কারো থাকবে না আমন একটি উদাহরণ দেখুন –

উদাহরণ দেখুন

User-agent: *

Disallow:

Sitemap: https://bd24blog.com/sitemap_index.xml

User-agent: GoogleBot User-agent: Slurp Disallow:

কোন একটা নির্দিষ্ট বটের ভিজিট যদি বন্ধ করতে চান তাহলে নিচের মত কোড ব্যাবহার করুন –

উদাহরণ দেখুন

User-agent: Teoma Disallow: /

এই ফাইলটি দ্বারা যদি আপনার সাইটের কোন URL বা পেজ crawl করা বন্ধ করে দেন তারপরেও কিছু সমস্যার কারনে এই পেজগুলি কোথাও কোথাও দেখাতে পারে। যেমন রেফারেল লগ এ URL গুলি দেখাতে পারে। তাছাড়া কিছু কিছু সার্চ ইঞ্জিন আছে যাদের এলগরিদম খুব উন্নত নয় ফলে এসব ইঞ্জিন থেকে যখন স্পাইডার/বোট crawl করার জন্য পাঠায় তখন এরা robots.txt ফাইলের নির্দেশনাকে উপেক্ষা করে আপনার সব URL crawl করে যাবে।এসব সমস্যা এড়াতে আরেকটা ভাল পদ্ধতি হল এই সমস্ত কন্টেন্টকে htaccess ফাইল দিয়ে পাসওয়ার্ড বা বন্ধ করে রাখা।

Robots.txt ফাইল কি? Create Robots.txt File

Seo Friendly Blogger Template Free Download

rel=”nofollow” এর ব্যাপারে সতর্ক থাকুন

কোন লিংকে rel এট্রিবিউট এ “nofollow” সেট করে দিয়ে গুগল বা সার্চ ইঞ্জিনকে বলে দিতে পারেন যে এই সমস্ত লিংক যেন সে crawl না করে। যদি আপনার সাইট কোন ব্লগ বা ফোরাম হয় যেখানে মন্তব্য করা যায় তাহলে কমেন্ট অংশকে এভাবে nofollow করে দিয়ে রাখতে পারেন।

এতে করে আপনার ব্লগ বা ফোরামের খ্যাতি ব্যাবহার করে নিজের সাইটের rank বাড়াতে পারবেনা। আবার অনেক সময় অনেকে আপত্তিকর সাইটের ঠিকানা আপনার সাইটে দিতে পারে যা আপনি চান না। এছাড়াও এমন সাইটের লিংক দিতে পারে যেটা গুগলের কাছে spammer, এতে করে আপনার সাইটের খ্যাতি নষ্ট হবে।প্রতিটি লিংকে nofollow না দিয়ে robot মেটা

ট্যাগেও nofollow দিলে একই কাজ করবে।